Kategorie: b.r.m.

AERO 2024 Impressionen

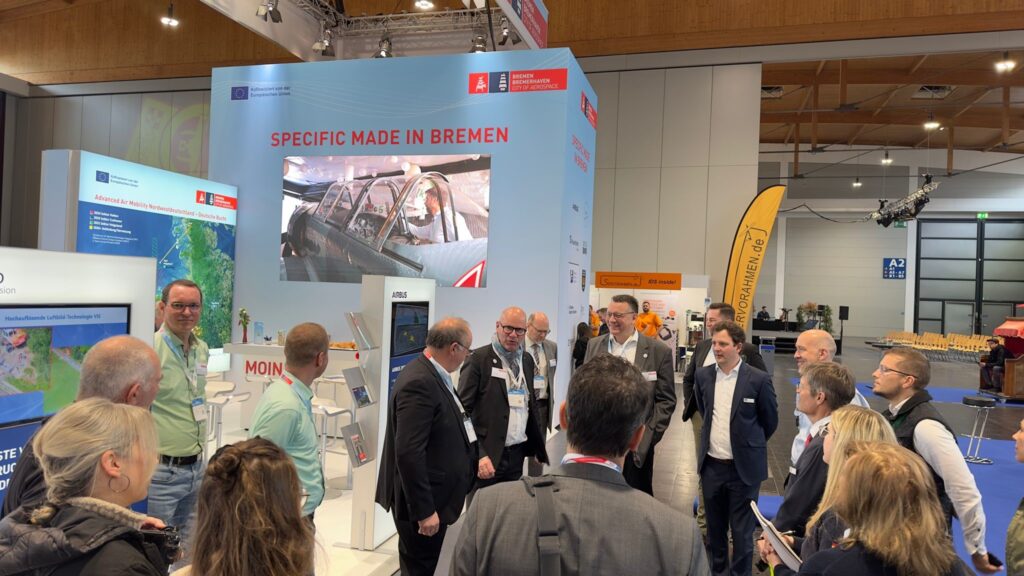

Ein fröhliches “Moin Moin” vom Gemeinschaftsstand des Landes Bremen (Halle 2 Stand 309) wünscht Ihnen die b.r.m. IT & Aerospace GmbH. Zusammen mit weiteren Bremer Unternehmen teilen wir toll Erfahrungen der diesjährigen AERO in Friedrichshafen. Daher hier einmal unsere tollen Impressionen.

Wir freuen uns weiterhin auf Ihren Besuch bei der AERO und dem Bremer Gemeinschaftsstand in Halle 2 Stand 309. Herr Harald Rossol und Herr Markus Rossol erwarten Sie.

AERO und AERO Drones 2024

In 5 Tage geht es los und wir freuen uns darauf!

b.r.m. IT & Aerospace stellen gemeinsam mit Partnern auf dem Gemeinschaftsstand des Landes Bremen in der Halle 2 Stand 309 aus.

Wir freuen uns auf Ihren Besuch. Harald Rossol und Markus Rossol erwarten Sie.

Partner auf den Landesstand Bremen

AIRBUS Defence & Space

T +49 421 539 4562 | www.airbus.com

AVIASPAC E BREMEN

T +49 421 2208275 | www.aviaspace-bremen.de

Cast Coil

T +49 176 8789707 | www.castcoil.de

DRO NIQ

T +49 69 509547 400 | www.droniq.de

Flugplatz Oldenburg-Hatten

T +49 4481 927976 | www.edwh.de

Fraunhofer IFAM

T +49 421 2246-0 | odcc.ifam.fraunhofer.de

Hanseatic Aviation Solutions

T +49 421 59679420 | www.hanseatic-avs.de

Lufthansa Industry Solutions AS

T +49 40 5070 30000 | www.lhind.dlh.de

Luftfahrtbehörde Land Bremen

T +49 421 36197590 | www.haefen.bremen.de/luftfahrt

OptoPrecision

T +49 421 9496110 | www.optoprecision.de

Sigma Aerospace Metals

T +49 421 69 4134-20 | www.sigmaaero.de

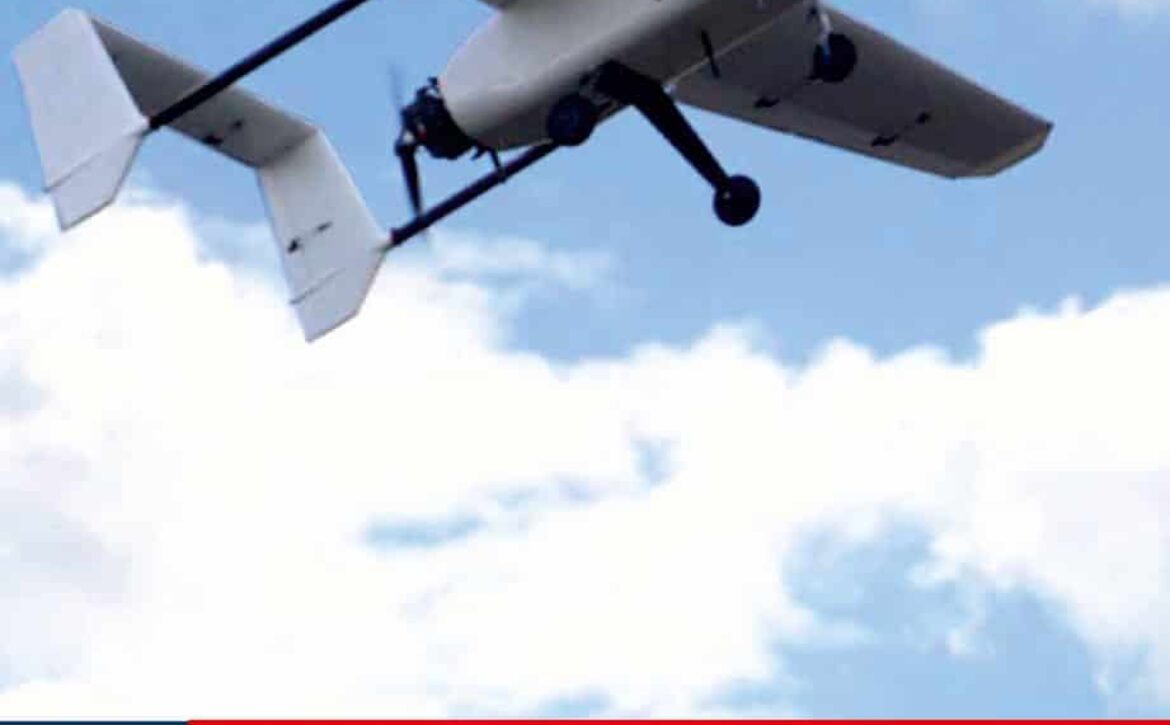

UNBEMANNTE LUFTFAHRT AUS BREMEN

Das Land Bremen fördert erfolgreich im Rahmen des Luft- und Raumfahrtinnovationsclusters Bremen Bremerhaven City of Aerospace Unternehmen und Forschungseinrichtungen die Entwicklung und Anwendungen von Unbemannten Luftfahrtsysteme (UAS). Kompetenzen wurden im Bereich Entwicklung und Produktion von Hard- und Softwaresystemen, Luftfahrzeugsdesign, Avionik, Navigation, Sensorik aufgebaut. Gleichzeitig stehen Anwendungen von UAS zur Erfüllung verschiedenster Aufgaben im Fokus wie z.B. die Ausführung hoheitlicher Aufgaben in der Deutschen

Bucht durch den Einsatz von Drohnen als Träger von Sensortechnik oder den Aufbau von Bodenstationen für UAS. Mit der Unterstützung der Advanced Air Mobility (AAM) Initiative Nordwestdeutschland und Deutsche Bucht & UAS-Leitstelle Bremen (USSP) wird das Land Bremen die Weiterentwicklung der UAS Aktivitäten der im Land ansässigen Akteure in Zusammenarbeit mit

Niedersachsen weiter fördern.

BREMEN

LUFT- UND RAUMFAHRTSTANDORT

In der Luft- und Raumfahrtindustrie erwirtschaften mehr als 140 Unternehmen und 20 Institute mit rund 12.000 Beschäftigten mehr als 4 Milliarden Euro pro Jahr. Gemessen an der Einwohnerzahl hat Bremen die höchste Beschäftigungsdichte in diesen Branchen in Deutschland. Zukunftsorientierte Arbeitsplätze, vor allem für hochqualifizierte Menschen, kennzeichnen die Raumfahrtindustrie

und den Luftfahrtsektor. Die Spitzenforschung im Land Bremen unterstützt die Industrie nachhaltig u. a. in den Bereichen Materialwissenschaften und Produktionstechnologien, Raumfahrtsysteme, Fernerkundung, Bionik und Robotik.

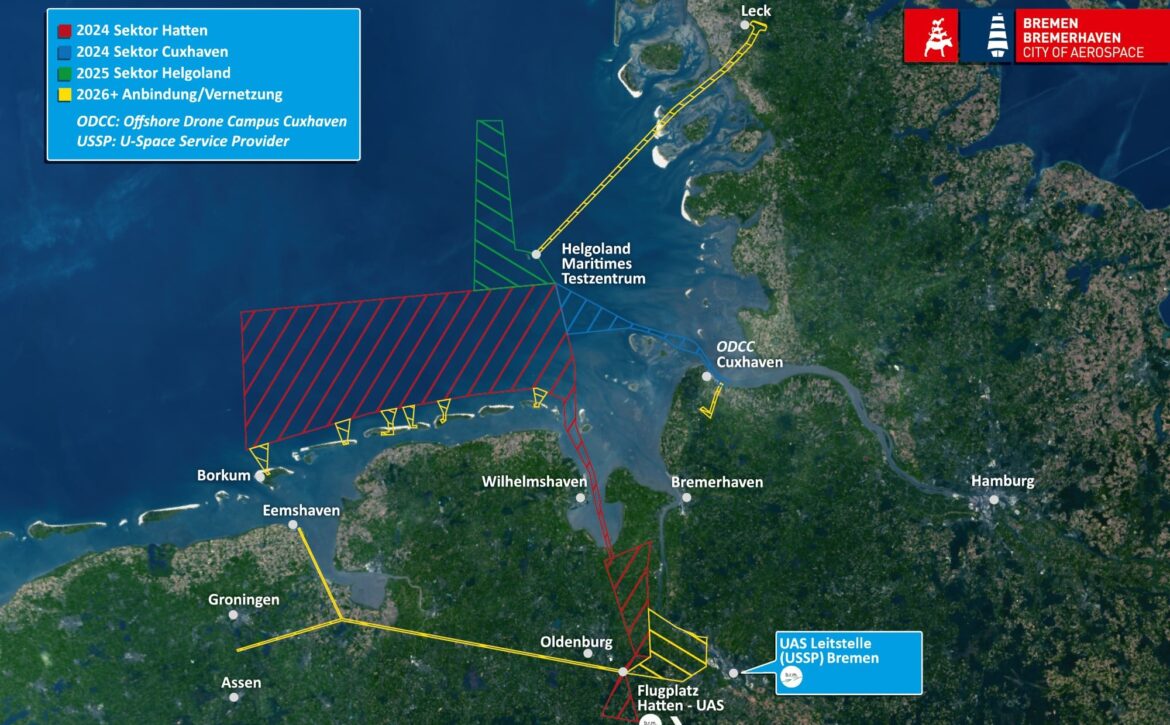

ADVANCED AIR MOBILITY INITIATIVE

GESAMTZIEL DES VORHABENS

Ziel der Initiative(AAM-NW) ist der sukzessive Aufbau von Luftraumstrukturen innerhalb derer der Betrieb von UAS einer erheblichen Koordinationsvereinfachung & -Automatisierung sowie Erhöhung der Sicherheit unter Berücksichtigung aller relevanten Luftraumnutzer erfährt. Damit sollen die Erfahrungen für die Schaffung zukünftiger hochautomatisierter Betriebsstrategien gesammelt werden, indem eine Verknüpfung und Einbindung von UAS Traffic Management (UTM) in existierende Air Traffic Management (ATM) Systeme erfolgt.

Das Land Bremen, mit dem Schwerpunkt der UAS-Leitstelle und das Land Niedersachsen, mit dem Schwerpunkt der Fluggebiete und flugtechnischen Infrastrukturen stehen hier kooperativ involviert zusammen, um die gemeinsame Ertüchtigung des Luftraumes für die Advanced Air Mobility zu unterstützen.

Die Hauptakteure dieses Vorhabens sind: Aviaspace Bremen e.V., b.r.m. IT & Aerospace GmbH, Droniq GmbH, Flugplatz Oldenburg-Hatten GmbH, Flugschule Borkum GmbH, Fraunhofer IFAM, Offshore-Drone-Campus-Cuxhaven (ODCC), Optoprecision GmbH.

Darüber hinaus umfasst die Gruppe der betroffenen Stakeholder inzwischen über 200 Akteure, die sich in unterschiedlicher Art und Weise am Gesamtvorhaben engagieren.

Weiterhin erfolgt perspektivisch eine Einbindung der weiteren norddeutschen Bundesländer (Mecklenburg-Vorpommern, Hamburg, und Schleswig-Holstein), additiv, d.h., dass die geplanten Bundesländer parallel geeignete Strukturen erarbeiten, um zu einem späteren Zeitpunkt mit der AAM-NW zusammenzuwirken.

EINFÜHRUNG

Vornehmlich wird unter Advanced Air Mobilty (AAM) eine Integration von unbemannten oder autonomen Luftfahrzeugen in einen gemeinsamen Luftraum mit der bemannten Luftfahrt verstanden, welche die Möglichkeit bieten, „sowohl Metropol- als auch ländliche Regionen unabhängig von bestehenden bodengebundenen Verkehrsinfrastrukturen schnell, sicher, nachhaltig und bezahlbar miteinander zu verbinden“.1 Gerade in ländlichen Regionen eignen sich aber auch kleinere UAS2 zur Übernahme bestimmter Monitoring- und Transportaufgaben.

Die deutsche Bucht, deren Inseln und angrenzenden Küstenländer bieten hier großes Potential um mit zunächst risikoärmeren Einsätzen und (kleineren) Fluggeräten außerhalb der Sicht Betriebsprozesse der unbemannten Luftfahrt zu erproben und diese Stück für Stück in die existierende bemannte Luftfahrt zu integrieren. Auch der Schifffahrt und dem Naturschutz müssen in der deutschen Bucht insbesondere Beachtung geschenkt werden.

Ein sukzessiv aufgebauter Erfahrungsschatz durch regelmäßigen UAS Betrieb erlaubt die fortlaufende Erprobung von Betriebsabsprachen bis hin zur Hochautomatisierung der Flugbewegungskoordination durch eine zentrale Leitstelle und fördert gleichzeitig das Vertrauen in diese neue Technologie. An dieser Stelle setzt das Vorhaben an. Im Anschluss erfolgt eine Transformation des generierten Know-Hows in Gebiete und Missionen mit höherem Risiko z.B. in urbanen Räumen, höheren Nutzlast und auch Personen an Bord.

ZEITLICHER HORIZONT UND AUSBAUSTUFEN

Allen Phasen gemeinsam ist ein sukzessiver Aufbau der entsprechenden BVLOS-Flugbereiche (beyond visual line of sight / außerhalb der Sichtweite). Im Fokus steht dabei die Nutzung und Ausleuchtung des Very-Low-Level-Airspace (VLL). Für die jeweiligen Ausbaustufen ist eine Abdeckung durch das Luftlagebild zu erreichen und aufeinanderfolgend zu erweitern. Die entsprechenden Sichtbarkeiten von bemannter allgemeiner Luftfahrt, Luftrettung, Behörden und Organisationen mit Sicherheitsaufgaben (BOS) und UAS, im BVLOS-und VLOS-Betrieb (visual line of sight), sind gegenseitig sicherzustellen, zu erproben und nachzuweisen. Insbesondere da diese Aktivitäten vor dem Realbetrieb einen Testbetrieb erfordern.

Phase 0 – 2023 Vorarbeiten der Initiative: Zusammenstellung und Einbindung aller relevanten Luftraum-Teilnehmer

Phase 1 – 2024: BVLOS Bereiche Hatten – Deutsche Bucht inkl. Erprobungsbetrieb (roter Kartenbereich)

Phase 2 – 2024-2025: BVLOS Bereiche Cuxhaven & Helgoland inkl. Anschluss an Phase 1 inkl. Erprobungsbetrieb (blauer und grüner Kartenbereich)

Phase 3 – 2026-2028: Ausweitung und Anbindung weiterer Flugplätze wie z.B. Ostfriesische-Inseln, Leck und Nordholz inkl. Erprobungsbetrieb (Gelber Kartenbereich) „Von Separation zu Integration“

Phase 4 – Vision 2030 weitere Entwicklung in den jeweiligen aufgebauten U-Space(s) hin zur nahtlosen Anknüpfung an den „U4“ des SESAR ATM Masterplans ab 2035

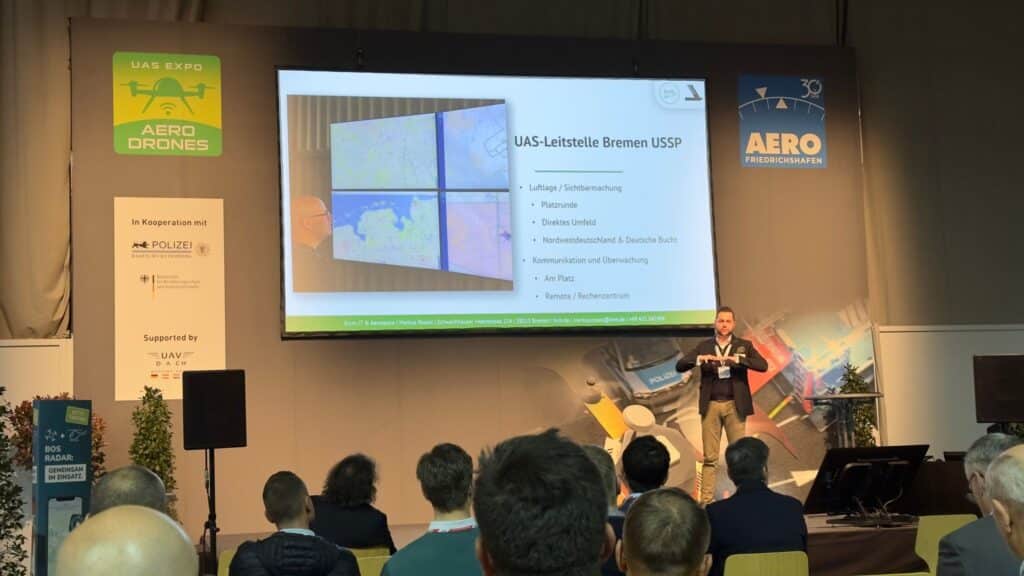

UAS-LEITSTELLE BREMEN (USSP)

Ob für industrielle, universitäre, behördliche, sicherheitsdienstliche oder zivile Zwecke: der Einsatz von

Drohnen wird in den nächsten Jahren stark ansteigen und sehr wahrscheinlich sogar das Aufkommen im bemannten Flugverkehr übertreffen. Zur Koordinierung bedarf es zentraler Stellen, die Kollisionsvermeidung und entsprechende Ausweichverfahren für die unbemannte Luftfahrt initiieren können. Die EU DVO 2021/664ff sehen einen USSP (USSP = U-Space Service Provider) vor, der luftfahrttechnischen Dienste (z.B. Fluggenehmigungen und -aktivierung) digital für Drohnenbetreiber bereitstellt. Damit das AAM NW in diesem Sinne an der digitalen Transformation der Luftfahrt mitwirken kann ist aus Bremen heraus der Aufbau einer UAS-Leitstelle (USSP) geplant. Diese Leitstelle kann durch Echtzeitkoordination die bemannte Luftfahrt bei dringlich erforderlichen Einsätzen im VLL-Airspace schützen und gleichzeitig Luftraumnutzungspotentiale durch die unbemannte Luftfahrt eröffnen.

AAM Nordwest und Deutsche Bucht

Heute am 11.04. ab 10:00 Uhr findet der Workshop “Advanced Air Mobility Initiative Nordwestdeutschland und Deutsche Bucht (ehemals U-Space Nordwest)” beim IFAM (Frauenhofer) statt.

Die Teilnahmen erfolgen in Präsenz als auch via Online-Teilnahme statt.

Herr Harald Rossol und Herr Markus Rossol nehmen in Präsenz teil.

AERO 2024 – Vorträge

Auf der AERO 2024 in Friedrichshafen vom 17.04. – 20.04.2024 werden Vorträge aus der Luft- und Raumfahrt gehalten.

Wir beglückwünschen die Messe der allgemeinen Luftfahrt zu ihrem erfolgreichen bestehen und 30. Jubiläum.

Es gibt zusätzlich eine eigenständige dreitägige Fachveranstaltung AERODrones 2024, rund um das Thema unbemannte Luftfahrzeuge,

die auf der Bühne in der HALLE A2 vom 17.04. – 19.04.2024 stattfinden wird.

b.r.m. IT & Aerospace wird mit ihren Partnern, unterschiedliche Vorträge aus der unbemannten und bemannten Luftfahrt halten,

die im Kontext zu Drohnen, UAS, SORA, BVLOS, VLOS, USSP und U-Space stehen.

Auch die Weiterentwicklung der Bremer UAS Initiative vom gemeinsamen Projekt „U-Space Reallabor Nordwestdeutschland und Deutsche Bucht“ zur „Advanced Air Mobility Initiative Nordwestdeutschland und Deutsche Bucht“ wird vorgestellt.

| Mittwoch, 17.04.2024 | 11:00 – 11:45 Uhr | iConspicuity für die Allgemeine Luftfahrt von Markus Rossol |

| Mittwoch, 17.04.2024 | 16:00 – 16:30 Uhr | Advanced Air Mobility Initiative Nordwestdeutschland und Deutsche Bucht von Tim Strohbach und Markus Rossol |

| Donnerstag, 18.04.2024 | 13:45 – 14:15 Uhr | UAS-Leitstelle Bremen USSP der zukünftige U-Space Service Provider b.r.m. IT & Aerospace von Harald Rossol und Markus Rossol |

| Freitag, 19.04.2024 | 10:00 – 10:30 Uhr | Drohnen und die allgemeine Luftfahrt – Eine Einführung „Was dürfen Drohnenpiloten, wie planen Sie und was geht mich als Pilot das an?“ von Tim Strohbach |

| Freitag, 19.04.2024 | 11:00 – 11:30 Uhr | Hatten-UAS – die Blaupause für Flugplätze als Integration von bemannten und unbemannten Luftfahrzeugen von Harald Rossol |

Eine Übersicht von den verschiedenen Hallen und Konferenzzentren finden Sie hier: https://www.aero-expo.de/conferences/tagesprogramm

Besuchen Sie uns zur AERO 2024 auf unseren Gemeinschaftsstand des Landes Bremen in Halle 2 auf dem Stand 309

Kommen zu Sie uns, unsere Geschäftsführung um Herrn Harald Rossol und Herrn Markus Rossol freuen sich auf ein Kennenlernen. Sie erreichen uns per Telefon unter +49 421 34 14 94 und per Mail an brm@brm.de.

b.r.m. IT & Aerospace GmbH auf der AERO 2024

Die Aero 2024 findet am 17. – 20.04.2024 in Friedrichshafen statt. Wir, die b.r.m. IT & Aerospace GmbH, sind glücklich erneut auf dem Gemeinschaftsstand des Landes Bremen in der Halle 2 (Stand 309, Bremen) zu sein. Es wird hier das Portfolio von b.r.m. IT & Aerospace gezeigt: USSP, UAS, Drones, SORA, VLOS und BVLOS-Betrieb. Komplexe Aufgabenstellung aus der unbemannten Luftfahrt können erreicht werden. Vom Betriebskonzept bis hin zu Genehmigung.

Wir können unabhängig von dem Stand Ihrer Entwicklung sich den spezifischen Anforderungen der Advanced Air Mobility annehmen. Unsere große Erfahrung bietet Ihnen die Möglichkeit den entscheidenden Vorteil in der unbemannten Luftfahrt zu erlangen. Sei es die Entwicklung eines UAS oder umfangreiche europäische Aufstiegsgenehmigungen über 3600 km² zu erlangen

Als künftiger U-Space Service Provider (USSP) unterstützen wir Sie in allen Bereichen

Unsere Podiumsvorträge auf der AERO können Sie zu folgenden Zeiten hören und sehen.

Datum: Mittwoch 17.04.2024

Uhrzeit: 16:00 – 16:30 Uhr

Thema: Advanced Air Mobility Initiative Nordwestdeutschland

Referenten: Tim Strohbach und Markus Rossol

Datum: Donnerstag 18.04.2024

Uhrzeit: 13:45 – 14:15 Uhr

Thema: UAS Leitstelle Bremen (USSP)

Referenten: Harald Rossol und Markus Rossol

Markus Rossol und Harald Rossol freuen sich auf Ihren Besuch in der Halle 2, Stand 309.

Drohne – UAS – RPAS aus Bremen

b.r.m. IT & Aerospace GmbH, wir machen es möglich….

© WFB/Jens Lehmkühler

Lesen Sie hierzu den spannenden und Inhaltich tollen Beitrag des Pressedienste der WFB Bremen.

b.r.m. IT & Aerospace GmbH ist auf dem Weg zur ISO/IEC 27001

Der Weg zur Zertifizierung nach ISO/IEC 27001 „Informationssicherheit, Cybersicherheit und Datenschutz – Informationssicherheitsmanagementsysteme – Anforderungen“ ist mühsam und aufwändig. Die ersten Hürden hierzu wurden bereits erfolgreich überwunden und damit das erste Audit erfolgreich absolviert.

Die weiteren Zertifizierungsschritte finden im Laufe von Q2-Q3/2024 statt.

Nachdem im Februar dieses Jahrs bereits die EcoStep 5.1 Zertifizierung für unser integriertes Managementsystem erfolgreich rezertifiziert wurde runden wir unsere zukünftige Tätigkeit als USSP (U-Space Service Provider) mit der ISO/IEC 27001 als Ganzes ab.

Für weitere Informationen steht Ihnen Herr Marius Ammermann gerne zur Verfügung. Sie erreichen uns per Telefon unter +49 421 34 14 94 und per Mail an brm@brm.de.

Advanced Air Mobility – für eine fortschrittlichere Luftfahrt

Die Advanced Air Mobility (AAM) vereint die Begriffe Urban Air Mobility (UAM) und Regional Air Mobility (RAM). Allgemein ist mit UAM der Transport von Personen und Waren innerhalb eines Stadtgebiets gemeint und RAM gilt für den Transport von Personen und Waren für naheliegende Gemeinde.

Förderung des Drohnenverkehrs – Advanced Air Mobility

Bei der fortschreitenden Entwicklung von neuen Flugzeug- und Antriebskonzepten entstand der Bedarf nach einem Konzept, heute „Advanced Air Mobility (AAM), welches die Entwicklung und Implementierung von innovativen Technologien der Luftfahrt vereint. Dies umfasst die Integration von Luftfahrtzeugen mit neuen Antriebstechnologien in neuen Einsatzräumen, beispielsweise neue batteriebetriebene Senkrechtstarter in städtischen Gebieten. Damit allerdings das Konzept der AAM erfolgreich umgesetzt werden kann, sind weltweite Zulassungsstandards unter Berücksichtigung der Einbindung von UAS Traffic Management (UTM) und Air Traffic Management (ATM) notwendig. Es arbeiten mehrere Expertenteams aus der Luftfahrt zusammen, um Empfehlungen zur Entwicklung und Implementierung einer deutschlandweit einheitlichen Strategie an die Bundesregierung weiterzugeben.

Die Advanced Air Mobility bietet vielerlei Vorteile: Die zukünftigen Einsatzmöglichkeiten von unbemannten Flugobjekten werden nachhaltig vervielfacht und die Elektrifizierung oder andere Antriebsmöglichkeiten sorgen bei der Urbanen Luftmobilität für zukunftsfähige Alternativen zum herkömmlichen Personennahverkehr. Besonders in den Bereichen des Lufttransports in erweiterten urbanen Räumen und zwischen Städten, der Frachtzustellung und der Privat- und Freizeitflugzeuge können sich die Prinzipien der AAM in Zukunft ausdehnen. Ein zukünftiger Expresstransport und ein schnellerer und zielgenauerer medizinischer Notdienst sind nur zwei der vielen Anwendungsmöglichkeiten von diesen neuen Technologien. Das steigende Nutzungspotential der Drohnen kann durch AAM mit den neuesten Technologien und Sicherheitsstandards bedient werden. Zusammengefasst hat die Advanced Air Mobility die Aufgabe innovative Luftfahrttechnologien unter den Aspekten der Sicherheit, Nachhaltigkeit und Effizienz in die Luftfahrt zu integrieren.

Quelle:

https://www.ila-berlin.de/de/segmente/advanced-air-mobility

https://www.bavairia.net/luftfahrt/advanced-air-mobility-aam/

https://aertecsolutions.com/de/2023/01/30/die-infrastrukturen-in-der-advanced-air-mobility-i/

AERO 2024 – b.r.m. IT & Aerospace GmbH ist dabei

Die b.r.m. IT & Aerospace GmbH ist auf der Aero in Friedrichshafen vom 17. – 20. April 2024 auf unserem Gemeinschaftsstand des Landes Bremen in der Halle 2 (Stand 309, Bremen) dabei. Wir zeigen dort Dienstleistungen und Beratungen zu UAS, SORA, VLOS und BVLOS-Betrieb. Vom Betriebskonzept bis zur Genehmigung können selbst komplexe Aufgabenstellungen der unbemannten Luftfahrt erreicht werden.

Unser Team aus Luftfahrtexperten nimmt sich Ihrer spezifischen Anwendung der Advanced Air Mobility an, unabhängig an welchem Punkt der Entwicklung Sie stehen. Durch unsere jahrelange Erfahrung, beginnend mit der Entwicklung eines UAS, bis hin zur europäisch umfangreichsten Aufstiegsgenehmigung über 3600 km², können Sie den entscheidenden zeitvorteil erlangen, um im aufstrebenden Drohnenmarkt Erfolg zu haben.

Wir unterstützen Sie als zukünftiger U-Space Service Provider (USSP) in allen Bereichen der Flugführung und Freigaben. Profitieren Sie von unseren UTM Data Services, vom Wetterdienst bis zur elektronischen Sichtbarmachung und digitalen Luftlagebild.

Hatten-UAS German Flight Center ist das Erprobungszentrum für die unbemannte Luftfahrt, gelegen auf dem Verkehrslandeplatz Oldenburg-Hatten EDWH. Hatten-UAS kann jederzeit Unternehmen, Behörden und Organisationen mit Sicherheitsaufgaben, Hochschulen und wissenschaftlichen Einrichtungen für Projekte und Produkt- entwicklungen für unbemannte Luftfahrzeugsysteme unterstützen. Mit 5500 m² Hallenfläche, lizensierten Luftfahrzeugprüfern und einer Betriebsfläche, die auch gemischten Betrieb bemannt/unbemannt erlaubt, erhalten Sie Alles aus einer Hand: von der Bodenerprobung bis zur Kundenpräsentation.

Für Ihren UAS-Betrieb unterstützt Sie die Flugschule Borkum durch qualifizierte Ausbildungen für Ihre Fernpiloten. Als einer der ersten Antragsteller auf ein „Light UAS Operator Certificate“ (LUC) unterstützen wir Sie beim Aufbau eines qualifizierten Flugbetriebs.

Advanced Air Mobility Initiative Nordwestdeutschland und Deutsche Bucht & UAS-Leitstelle Bremen (USSP)

Die Advanced Air Mobilty (AAM) ist die Integration von unbemannten oder autonomen Luftfahrzeugen in einen gemeinsamen Luftraum mit der bemannten Luftfahrt.

Ziel der Advanced Air Mobility Initiative Nordwestdeutschland und Deutsche Bucht (AAM-NW) ist der sukzessive Aufbau von Strukturen innerhalb derer der Betrieb von UAS einer erheblichen Koordinationsvereinfachung & -Automatisierung sowie Erhöhung der Sicherheit unter Berücksichtigung aller relevanten Luftraumnutzer erfährt. In einem U-Space Reallabor sollen die Erfahrungen für die Schaffung zukünftiger hochautomatisierter Betriebsstrategien gesammelt werden.

Besuchen Sie uns auf der AERO in Halle 2 (Stand 309, Bremen) und besprechen Sie mit uns, wie Ihre zukünftigen UAS-Anwendungen einen gelungenen Start hinlegen. Bremen feiert zusätzlich dieses Jahr 100 Jahre Flugzeugbau, am 2. Januar 1924 nahmen die „Focke-Wulf Flugzeugbau A.G.“ ihren Betrieb auf. 100 Jahre später ist Bremen einer der herausragenden Standorte in der europäischen Luft- und Raumfahrt und die zukünftige UAS-Leitstelle Bremen (USSP) leitet die weitere Zukunft der Luftfahrt, der unbemannten Luftfahrt ein.

Für weitere Informationen steht Ihnen unsere Geschäftsführung um Herrn Harald Rossol und Herrn Markus Rossol gerne zur Verfügung. Sie erreichen uns per Telefon unter +49 421 34 14 94 und per Mail an brm@brm.de.

Wir freuen uns auf die Aero 2024 und ein Kennenlernen mit Ihnen.